De l'alerting à base de logs v2

Rédigé par dada / 06 novembre 2020 / Aucun commentaire

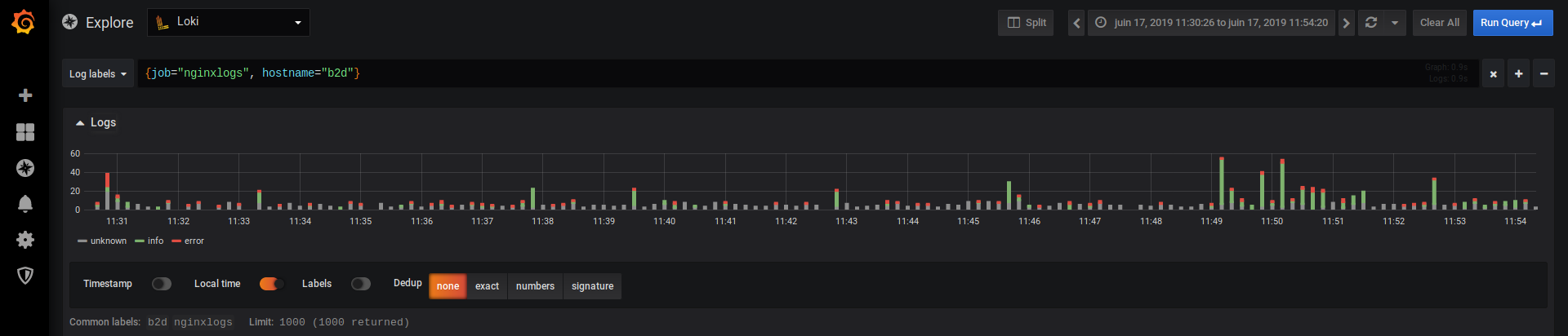

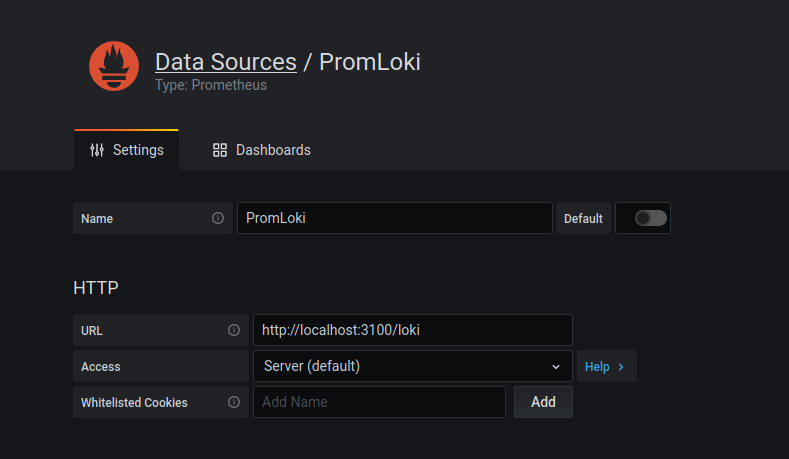

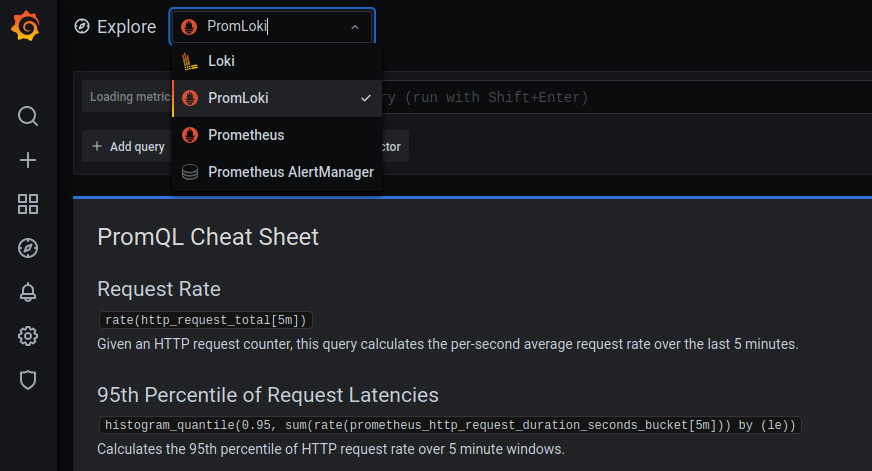

Configurer Loki comme Datasource de type Prometheus

- Name : ce que vous voulez

- URL : http://localhost:3100/loki

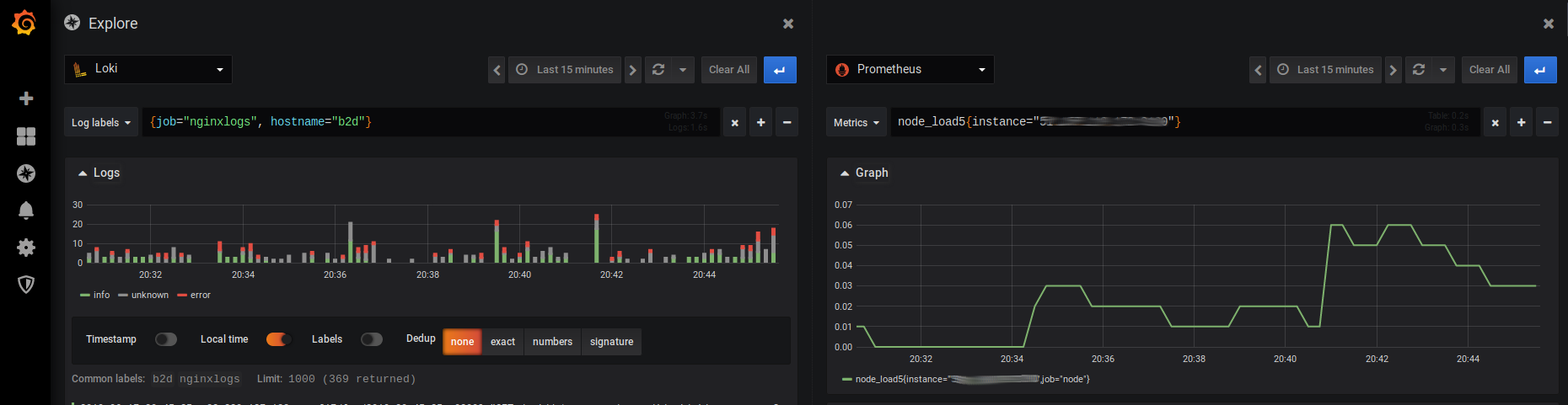

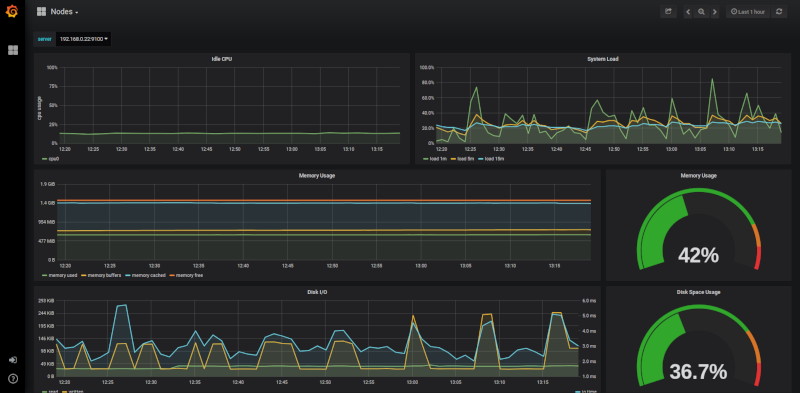

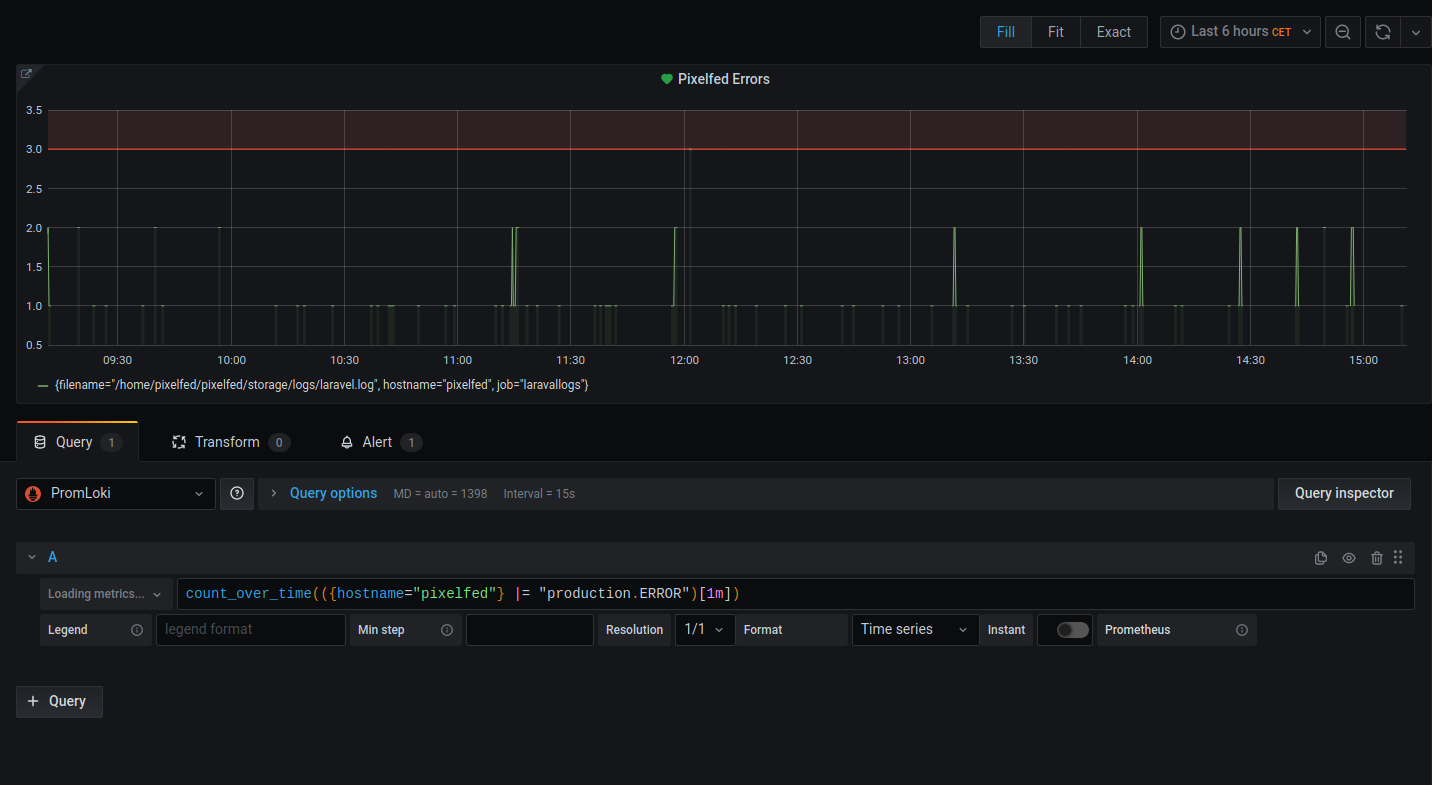

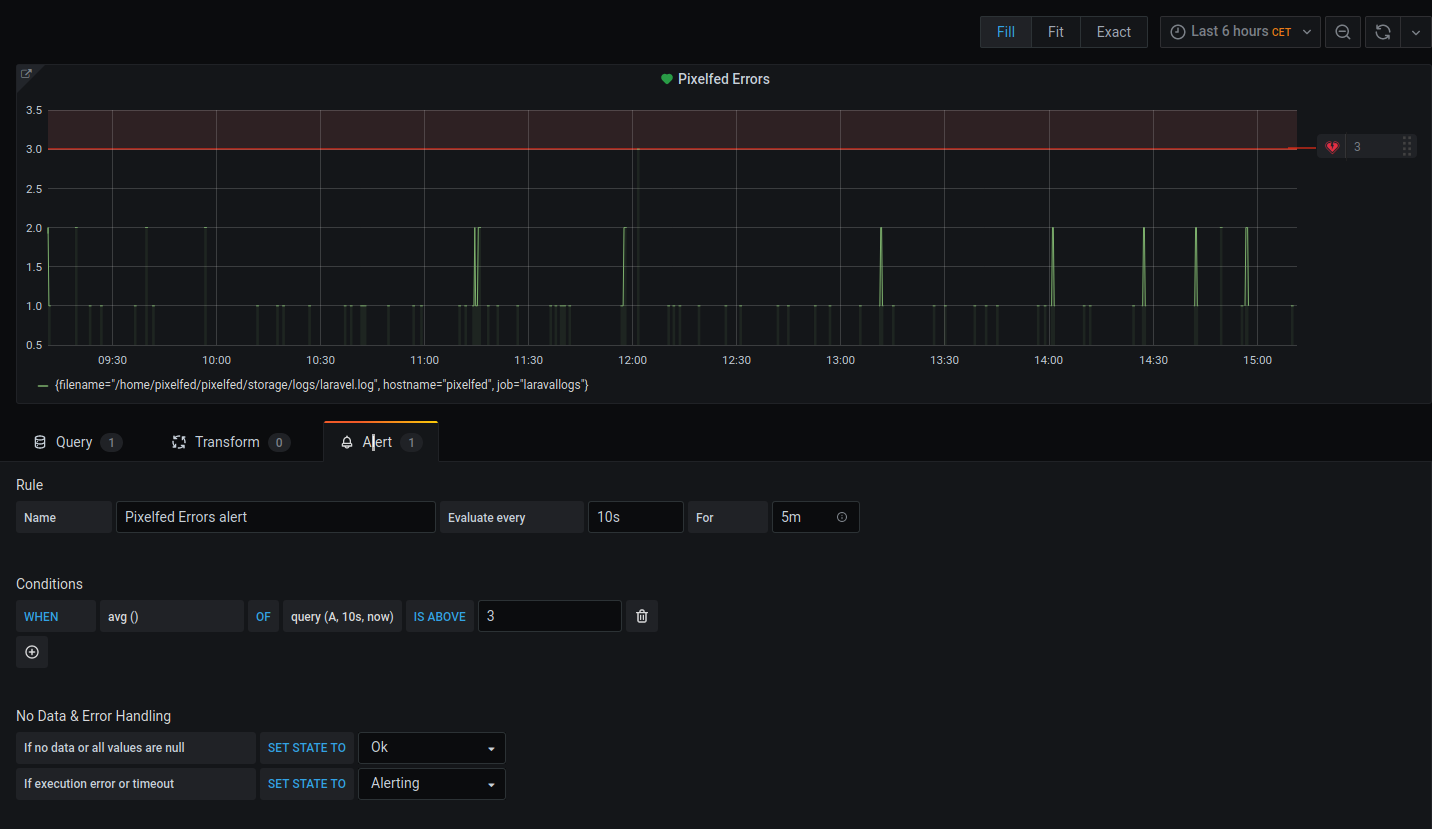

Créer un panel lié à une alerte

count_over_time(({hostname="pixelfed"} |= "production.ERROR")[1m])

- On évalue toute le 10s

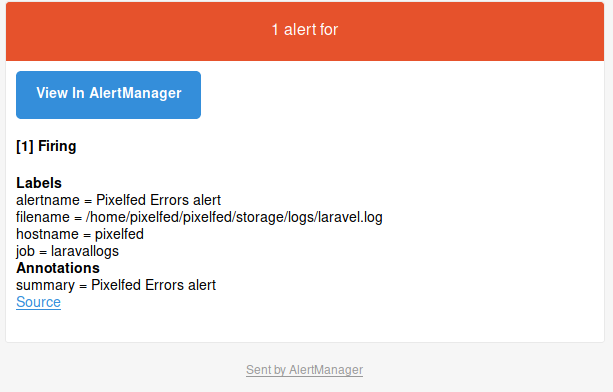

Recevoir les alertes